好百科首页 > 机器人是否能遵守人类的道德准则?

机器人是否能遵守人类的道德准则?

道德是人类社会的一种意识形态,是一种非强制性的约束法则。要让机器人理解人类所谓的道德,这有可能吗?

在热播美剧《纸牌屋》第三季中,有一个令人深思的情节:弗兰西斯(剧中总统)同意了美军使用无人机轰炸恐怖分子头目的作战方案,却因此伤及无辜,导致许多平民受伤。其中,失去双腿的阿拉伯裔美国公民默罕默德,一纸诉状将弗兰西斯告上法庭……

现实悲剧

作为一部颇有现实意义的电视剧,《纸牌屋》反映了当今社会的某些真实问题。如今,美军已经大量使用能够远程遥控、实施自动攻击的无人机,但也因此频发殃及无辜的惨剧。在阿富汗战争中,美军无人机每消灭1名恐怖分子,就会有50名无辜者连带丧生。同时,许多欧盟国家也在研发可以自主行动的战场机器人(俗称“杀人机器人”),这种武器虽然还未问世,但相关技术已经非常成熟。不久前,联合国安理会根据《特定常规武器公约》,呼吁各国中止这类机器人的研发和应用,并希望大家能够永久性地禁止开发具备独立杀人决策权的武器系统。

对这些钢铁机器而言,它们根本不知道什么是法律和道德,它们也无法对自己的行为负责——它可以判断对方是人还是机器,但却无法识别对方是士兵还是平民。士兵可以用常识判断眼前的女子,究竟是身藏炸药还是身怀六甲,但机器人根本就没有这个能力。它们甚至会误伤已丧失战斗意志或能力的伤员和准备投降的士兵。

联合国人权理事会特别报告员克里斯托弗·海因斯(Chris?topherHines)说道:“这种机器人无法遵守国际人权法和人道法,如果各国军队将‘杀人机器人’常规化,或是恐怖分子利用它们取代自杀式袭击,那就如同打开了现代的‘潘多拉魔盒’,后果不堪设想。而且,把是否杀害人类的判断权托给机器更是‘道义责任的缺失’。”

道德僵尸

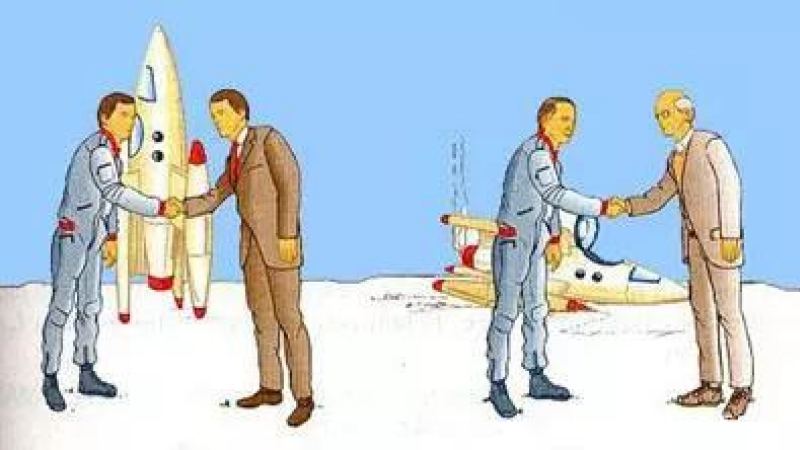

其实,海因斯的担忧不无道理,“杀人机器人”正从由人类远程遥控,向由计算机软件和传感器装置控制发展。未来,它们很有可能可以全自动执行识别敌人、判断敌情和杀死敌人等任务。那么,有没有办法通过计算机程序的设计,让机器人具有道德观念和法律意识呢?又或是给机器人颁发一个“行动执照”,将它的所作所为限定在一个合法的范畴之内呢?

这些问题激发了一批顶尖科学家的灵感,有人已进行了相关试验。英国布里斯托尔机器人实验室的专家艾伦·温菲尔德(AlanWinfield)及其同事,为机器人设计了这样一个程序——阻止其他拟人机器人掉进洞里。该程序的设计原理,源于美国著名科幻小说家艾萨克·阿西莫夫(IsaacAsimov)提出的机器人学三定律之一——机器人不得伤害人类,或坐视人类受到伤害。

试验一开始,机器人还能顺利完成任务:当拟人机器人向洞口移动时,机器人会冲上去将其推开,防止其掉进洞里。随后,研究人员又添加了一个拟人机器人,两个拟人机器人同时向洞口移动,救人机器人则要被迫做出选择。有时,其中一个“人”会被成功解救,而另一个“人”则会掉进洞里;有时,机器人甚至会想同时救出两个“人”。不过机器人在33次的测试中,有14次因为在救哪一个“人”的问题上不知所措而浪费了时间,结果导致两个“人”都掉进了洞里。2014年9月2日,在英国伯明翰召开的“迈向自主机器人系统”会议上,研究人员将这项实验的结果公开展示,并引起了世人的高度关注。

温菲尔德说:“虽然根据程序设定,救人机器人是可以对他人施救的,但它根本不理解这种行为背后的真正原因。实际上,它就是一具‘道德僵尸’——只知道根据程序指令行动,完成任务,仅此而已。我曾经不确定机器人能否做出道德伦理选择,经过这一系列实验,我仍然不知道答案。”

人类选择

温菲尔德所思考的问题对于所有人来说,都具有非常重要的意义。随着机器人日益融入人们的生活,这一问题更加需要明确的答案。

以无人驾驶汽车为例,当它有一天要在保全车内人员安全还是行人安全之间做出权衡时,你认为它会怎么选择呢?或许,连它自己都会不知所措。

虽然目前要解决这个问题还非常困难(这也是无人驾驶汽车至今都无法大规模正式上路的主要原因),但某些为军事战争设计的机器人,或许能够为我们提供一个初步答案。美国佐治亚理工学院(GeorgiaInstituteofTechnology)的计算机专家罗纳德·阿金(RonaldAkin),专门为一个名为“道德监督员”的军事机器人研制了一套运算法则。在模拟战斗测试中,它可以帮助机器人在战场上做出明智的抉择,例如在学校和医院等战争条例规定的受保护区附近不动用武器,且尽量减少人员伤亡。

不过,这道选择题还是相对简单的,如果遇到更加复杂的情况,结果往往会大不一样。例如,在打击“伊斯兰国”极端恐怖组织的战斗中,美军的无人机只能对其阵地实施有效轰炸,但当对方士兵融入当地平民中后,无人机就无所施措了。

目前,尽管在国际社会上禁止研发这类“杀人机器人”的呼声很高,但也有支持者认为,它们能更大程度地减少战场上信息不对称的情况,更加精确地打击目标,使用这种技术可以有效减少伤亡、挽救生命。

任何战争武器都是可怕的,如果有什么武器不由人操控那就更恐怖了。而且,要让机器人做出正确的道德伦理选择,也不是一朝一夕能够做到的,这涉及到一系列极其尖端复杂的人工智能技术。可以想象,在未来的某一时刻,战场上一定会出现为数不少的“杀人机器人”,但面对它们,人类其实还有一个更好的选择——和平!

注:所有文章均由中国数字科技馆合作单位或个人授权发布,转载请注明出处。

经验内容仅供参考,如果您需解决具体问题(尤其法律、医学等领域),建议您详细咨询相关领域专业人士。如需转载,请注明版权!

标题:机器人是否能遵守人类的道德准则? 网址:http://www.jrxk.cn/view/6102.html

发布媒体:好百科 作者:中国数字科技馆